Le premier tour de l’élection présidentielle a vu Marine le Pen et Emmanuel Macron se qualifier pour le second tour. Un scénario qui n’a surpris personne, encore moins les sondeurs qui ont placé ces deux candidats en tête pendant une bonne partie de la campagne. Mais les résultats du 1er tour de l’élection sont aussi l’occasion de comparer la performance des sondeurs. Quels sont ceux qui ont été les plus clairvoyants tout au long de la campagne ?

Des sondeurs globalement performants

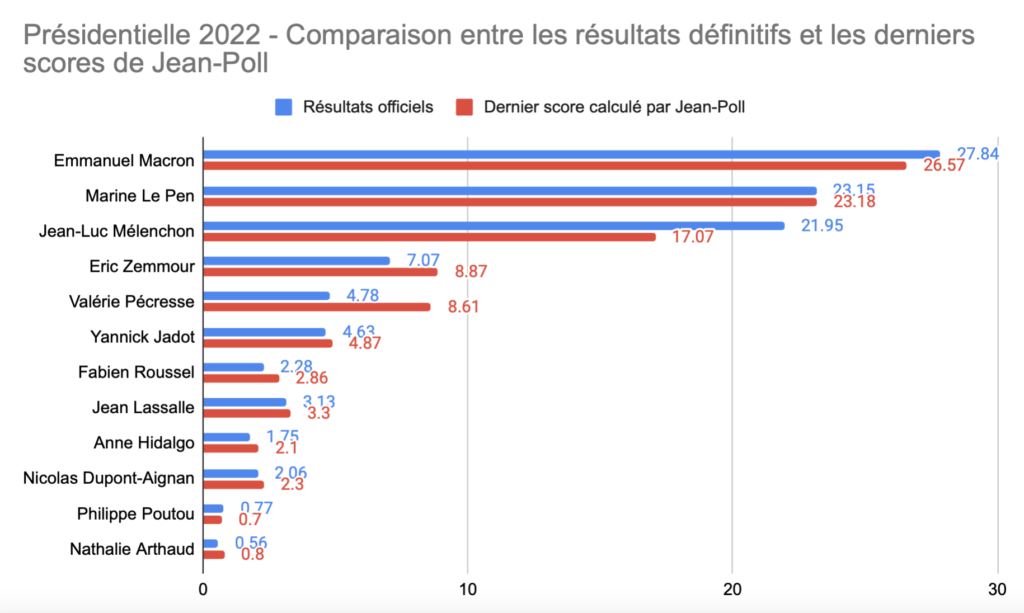

Une première approche pour évaluer la qualité des sondages dans cette présidentielle est de regarder les derniers sondages sortis par les différents instituts, juste avant le 1er tour. Pour obtenir une vue synthétique des derniers sondages parus avant l’élection, on peut choisir de regarder les scores calculés par des agrégateurs. Ces outils réalisent des moyennes (pondérées ou non) des derniers sondages parus. De notre coté, nous avons utilisé notre propre agrégateurs de sondages : Jean-Poll.

Premier constat : l’ordre d’arrivée est le bon pour le top 6. Derrière, il y a a quelques inversions : Jean Lassalle finit devant Anne Hidalgo, ou encore Nathalie Arthaud devant Philippe Poutou.

Un contre performance sur certains candidats

Certes, au global, la performance des sondeurs reste bonne. Mais quand on regarde candidat par candidat, il y a bien eu quelques couacs. C’est particulièrement le cas pour Jean-Luc Mélenchon ou Valérie Pécresse, tellement éloignés qu’ils sont largement en dehors de la marge d’erreur, comme le met bien en avant cette infographie de France Info. Le fait qu’ils soient en dehors de la marge d’erreur des derniers sondages montre bien que l’explication statistique n’est pas suffisante.

Les dynamiques elles non plus n’expliquent pas tout

Il est certain que des dynamiques extrêmement puissantes étaient à l’oeuvre au moment du scrutin :

- Jean-Luc Mélenchon était sur une dynamique haussière puissante, bénéficiant de l’effet « vote utile » à gauche, et mobilisant également des abstentionnistes

- Valérie Pécresse était à l’inverse en perte de vitesse, en continu depuis plusieurs mois, ses électeurs se déchirant entre ceux proches du centre droit compatible avec Emmanuel Macron et ceux attirés par une droite radicale ou extrême.

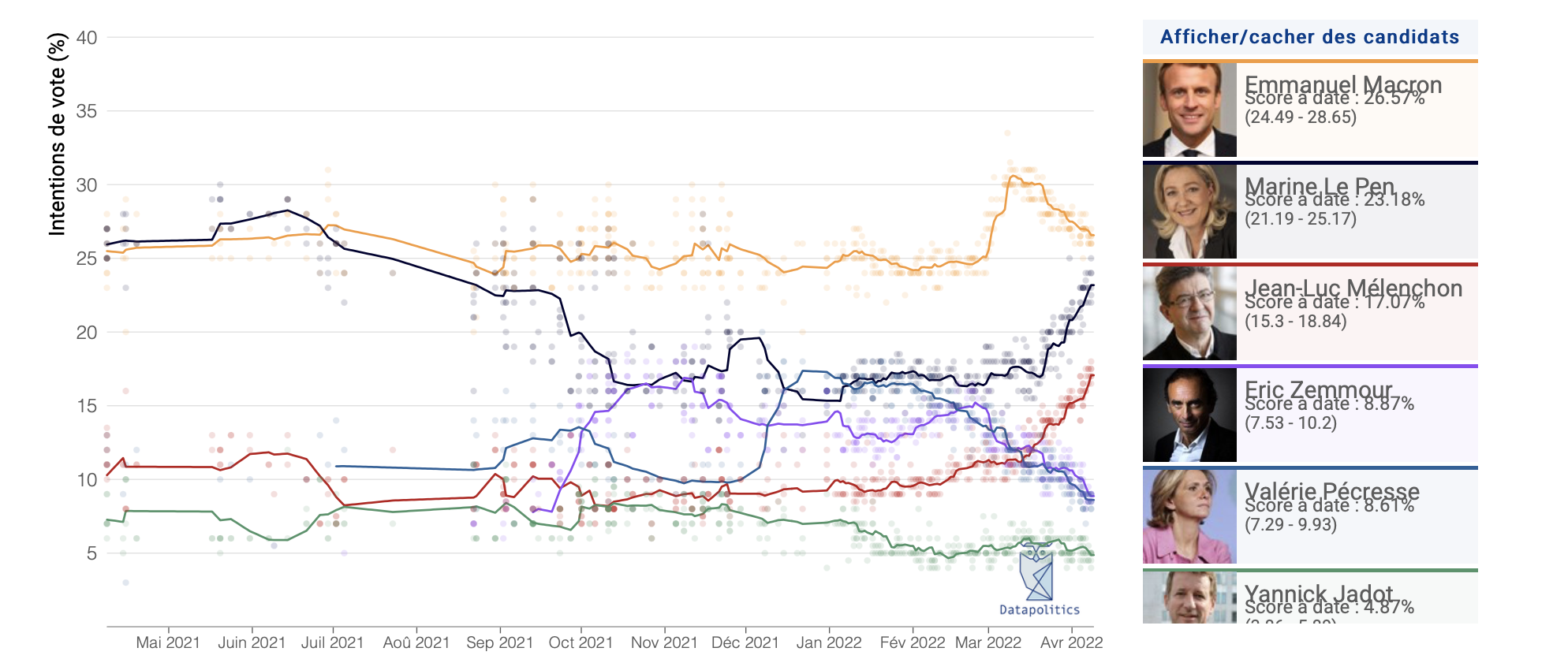

Agrégation de sondages - 1er tour

Les dynamiques fortes à l'oeuvre juste avant le premier tour : Le Pen, Mélenchon, Pécresse ou encore Zemmour.

Pour autant, les 5 points gagnés par Mélenchon entre les sondages et le scrutin ne proviennent pas des électeurs qui prévoyaient un autre vote à gauche, ce n’est en effet mathématiquement pas possible, car Anne Hidalgo, Yannick Jadot, Fabien Roussel, Nathalie Arthaud et Philippe Poutou n’ont perdu que 1,3 points entre le scrutin et les derniers sondages.

De même, la contre-performance de Valérie Pécresse ne peut qu’en partie s’expliquer par la sur-performance d’autres candidats. Cela ne tient mathématiquement tout simplement pas (faites les additions/soustractions, vous pourrez le constater par vous même).

Autre élément qui met en doute la question des dynamiques : Marine Le Pen bénéficiait également d’une dynamique extrêmement forte au moment du scrutin. Pourtant, son score final est quasiment parfaitement égal au score final de notre agrégation de sondages.

S’il ne s’agit pas d’une question de dynamique, il reste plusieurs explications possibles :

- Une participation « déformée ». Les électeurs de Mélenchon pourraient s’être mobilisés massivement dans les derniers mètres de l’élection, alors que ceux de Valérie Pécresse pourraient s’être désengagés, rendant ainsi non représentatifs les échantillons des sondeurs. Une sorte de surprise générale sur les participants au scrutin, que personne n’aurait vu venir.

- Un bug des sondeurs : qualité des échantillons, méthodes de redressement, etc. Une autre erreur aurait pu rendre les sondages trop décalés avec la réalité de l’opinion. C’est notamment l’hypothèse défendue par Luc Bronner du Monde sur Twitter.

L’écart au résultat, un bon juge de paix

Une bonne façon de répondre à la question : « y a-t-il un bug côté sondeur ? » est de comparer la performance des sondeurs. Après tout, si ces petits décalages s’expliquaient par des questions de méthodologie, on devrait bien trouver un sondeur qui s’en sort mieux que les autres.

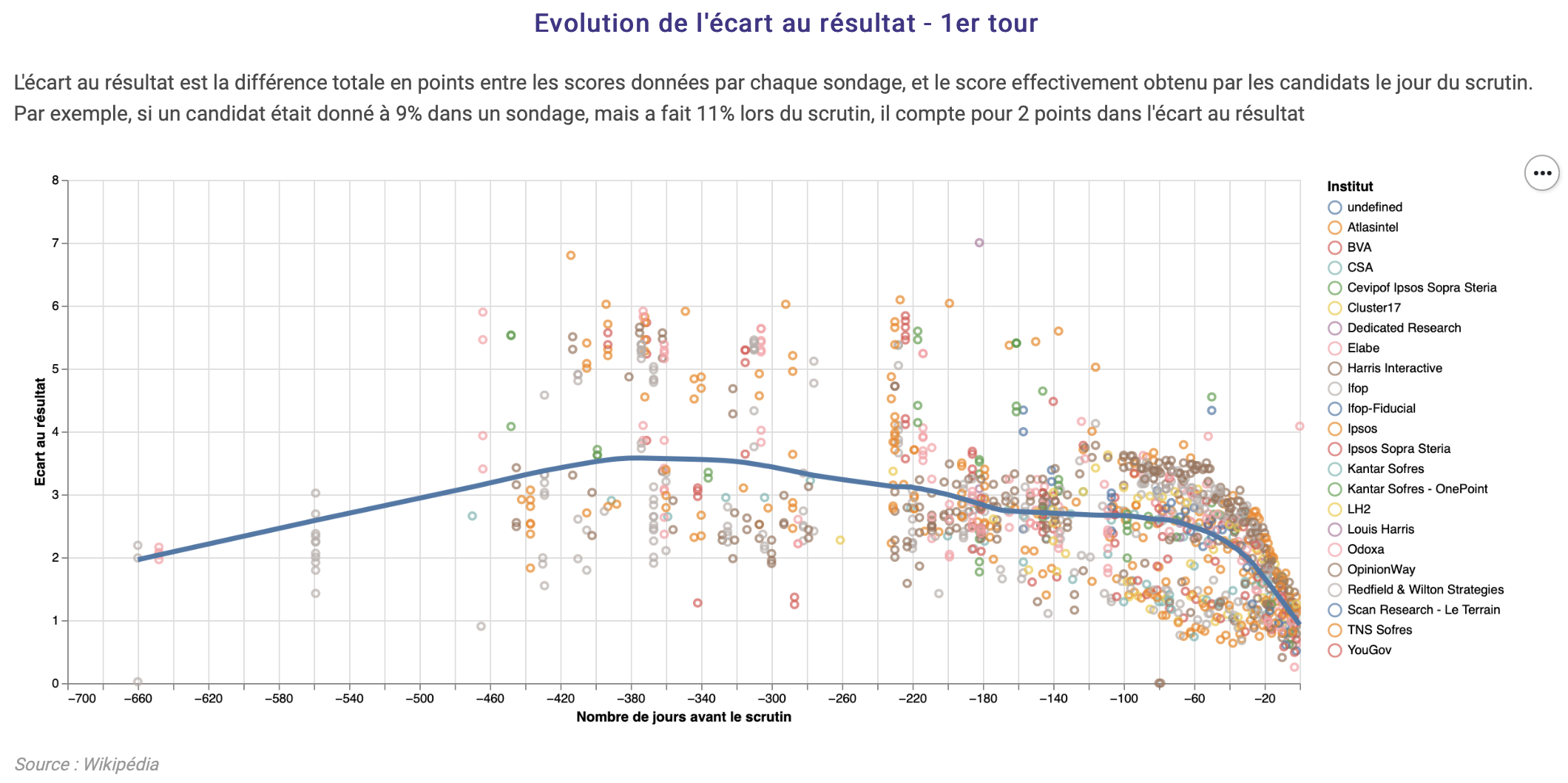

Nous avons utilisé une méthode inspirée des travaux de FiveThirtyEight aux Etats-Unis, consistant à comparer les sondages aux résultats de l’élection. Mais comme les sondages ne sont pas des prédictions mais des photos de l’opinion à date, notre approche calcule un écart entre l’erreur réalisée par un sondage et l’erreur attendue. L’erreur attendue est l’erreur qu’on s’attend à avoir dans ce sondage en fonction de ses caractéristiques : taille de l’échantillon, nombre de jours avant le scrutin, nombre d’hypothèses testées, etc. Cette méthodologie est expliquée en détails ici.

Pour se représenter visuellement ce qu’est cette notion d’erreur attendue, on peut faire un zoom sur une variable clé : la date du sondage. Le graphique ci-dessous représente tous les sondages parus pour les 1er tours des élections 1988 à 2022. Plus les points sont hauts, plus les sondages correspondant sont éloignés du résultat. On voit très nettement que plus on s’approche du scrutin, plus les sondeurs sont proches du résultat final.

La courbe bleue représente l’erreur attendue en fonction de la date du sondage. On peut la voir comme une moyenne. Si un sondage est au dessus de la courbe il s’est plus trompé que les autres. En dessous, il s’est moins trompé.

Un autre avantage de cette approche et qu’elle permet de se faire un avis sur l’ensemble des sondages publiés par un institut. En effet, en prenant uniquement le dernier sondage publié, on prend le risque de donner une bonne note à un institut qui aurait eu un coup de chance, ou inversement de pénaliser un institut qui n’aurait pas eu de chance avec un sondage.

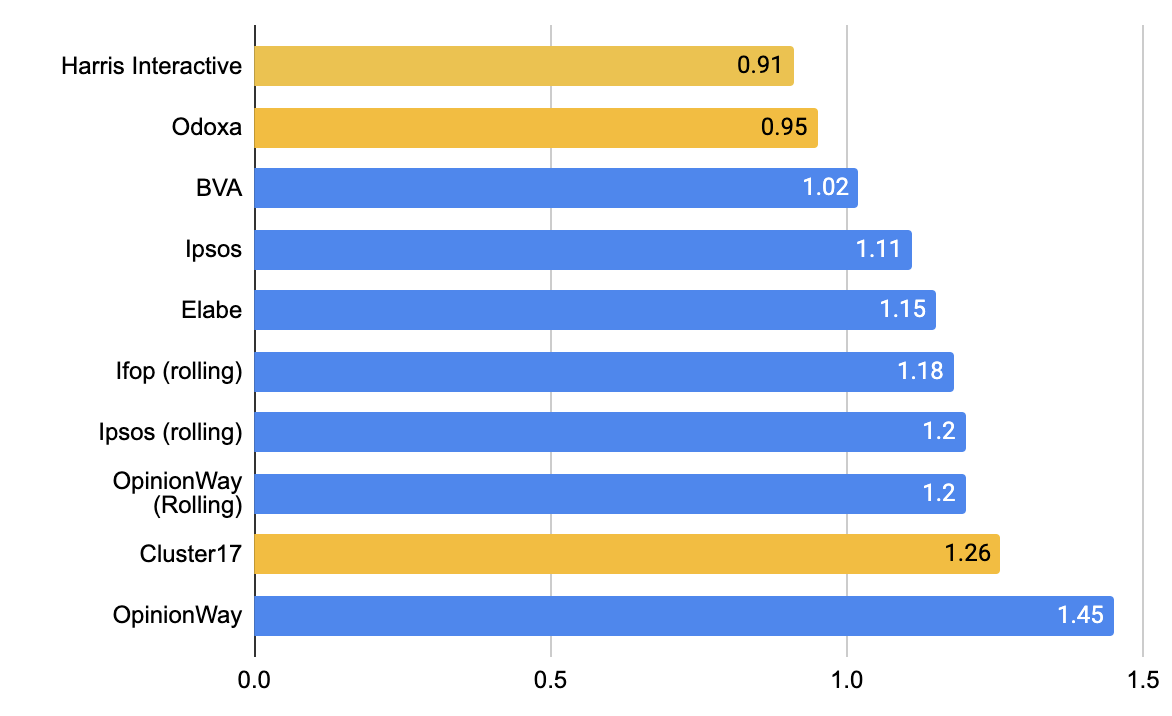

Odoxa, Cluster17 et Harris Interactive au dessus du lot

Nous avons calculé l’écart à l’erreur attendue pour l’ensemble des sondeurs, sur tous les sondages de 1er tour de la présidentielle 2022. Et voici les résultats. Notons que nous avons uniquement conservé ici les sondeurs ayant effectué 10 sondages ou plus dans cette présidentielle, pour éviter de distribuer trop facilement des bonnes notes aux sondeurs qui n’auraient réalisé que très peu de sondages juste avant le scrutin.

Odoxa, Cluster 17 et Harris Interactive partagent donc les 3 meilleurs marches du podium. A l’inverse, Opinion Way et Ipsos sont sur les 2 dernières marches, et sont notés B.

| Institut | Performance | Nombre de sondages de 1er tour | Note |

|---|---|---|---|

| Odoxa | -0.25 | 14 | A |

| Cluster17 | -0.18 | 28 | A |

| Harris Interactive | -0.16 | 106 | A |

| BVA | -0.12 | 23 | A |

| Elabe | -0.07 | 51 | A |

| Ifop | -0.03 | 141 | A |

| Ipsos | 0.14 | 73 | B |

| OpinionWay | 0.22 | 119 | B |

2 observations qui nuancent ces résultats :

- D’abord, aucun institut ne réalise une mauvaise performance. Tous sont en fait très proches. Ceci s’explique probablement par l’uniformité des méthodes mises en place (méthode des quotas + redressements). La régulation de la commission des sondages ou encore l’absence d’institut politisés sont d’autres explications possibles.

- Enfin, la question des rollings. On remarque que les 3 derniers du classement sont aussi les 3 seuls à avoir fait des sondages de types « Rolling ». Ce type de sondage est un peu particulier : c’est le même panel qui est interrogé, parfois quotidiennement, avec des tactiques permettant d’éviter d’interroger tout le monde chaque jour pour éviter la lassitude du répondant. Ce type de démarche peut toutefois conduire à des phénomènes d’usure ou de réponse « automatique » des participants lassés. Les Rolling ont-ils plombé les notes de ces 3 instituts ?

Le TOP 3 aussi meilleur dans la dernière ligne droite ?

Pour boucler la boucle, revenons sur les résultats du 1er tour. Nous avons vu que les résultats étaient particulièrement problématiques sur 2 candidats : Jean-Luc Mélenchon et Valérie Pécresse, et que :

- l’explication statistique n’était pas suffisante (le résultat est en dehors de la marge d’erreur)

- les dynamiques ne pouvaient pas à elles seules expliquer ce phénomène (quelques additions montrent que ça ne suffit pas)

Si il s’agit d’un bug côté sondeur (échantillons, méthode, autre…) on devrait observer que les sondeurs les mieux notés par notre algorithme ont été plus performants sur l’estimation du score de Jean-Luc Mélenchon et Valérie Pécresse juste avant le scrutin, puisqu’ils ont été meilleurs sur l’élection général.

Verdict en 3 graphiques.

C’est plutôt le cas sur Jean-Luc Mélenchon, où les 2 derniers sondages d’Harris Interactive et Cluster 17 sont en effet les plus proches du résultat final. En revanche, sur Valérie Pécresse, ils font partie des plus éloignés.

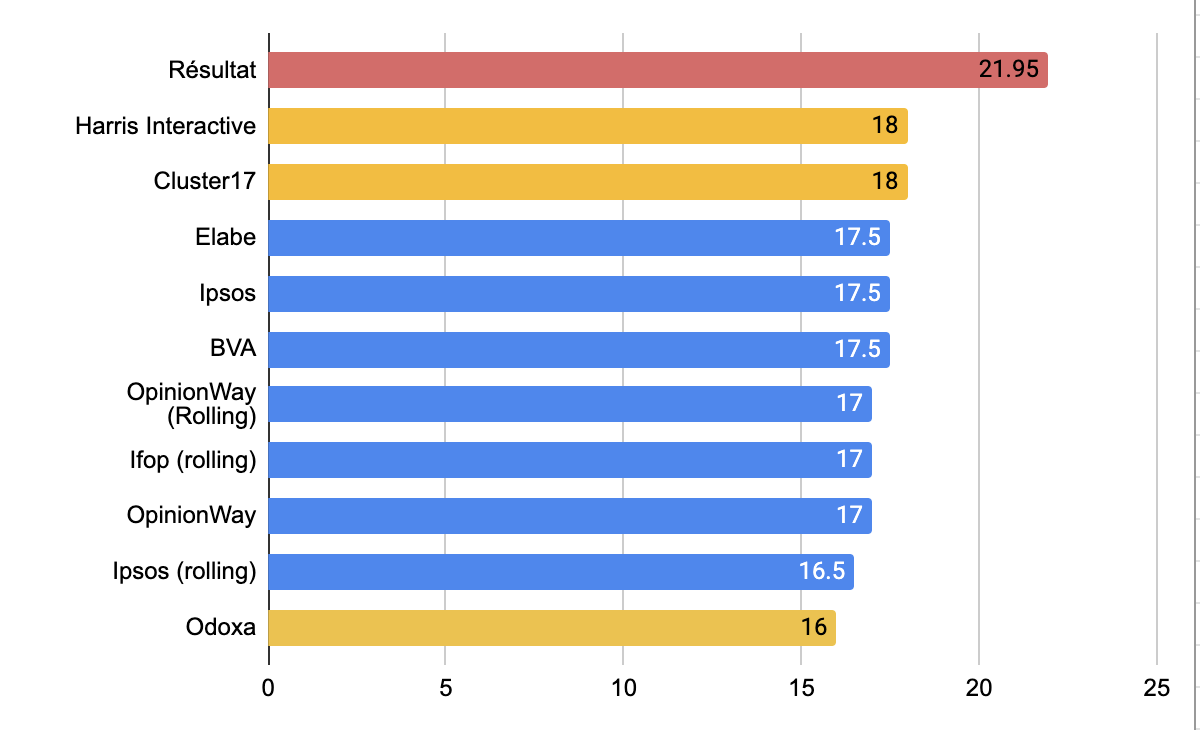

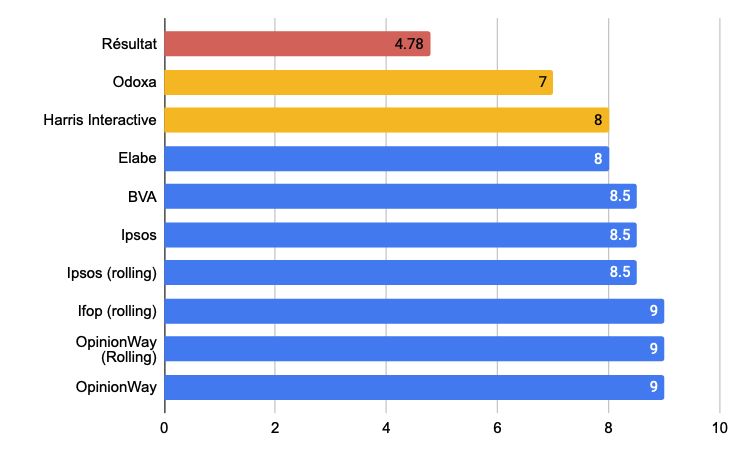

Pour juger la qualité globale des sondeurs dans la dernière ligne droite, nous avons pris les derniers sondages de chaque institut. Et effectivement, les 2 meilleurs performances sont réalisées par les instituts les mieux notés par notre algorithme (ici en jaune).

Score de Mélenchon dans le dernier sondage de chaque institut

Harris Interactive et Cluster 17 sont les plus proches du résultat.

Score de Pécresse dans le dernier sondage de chaque institut

Odoxa et Harris Interactive sont les plus proches du résultat.

Nous avons fait le même exercice avec l’écart moyen au résultat :

Ecart moyen au résultat final de l'élection

Harris Interactive et Odoxa ont en moyenne les meilleurs résultats.

Conclusion

Les différences ente instituts semblent bien être une partie de la réponse à notre question. Harris Interactive en particulier se trouve à la fois bien noté par notre algorithme, et a aussi été le plus proche du résultat de l’élection dans son dernier sondage.

Toutefois, malgré cela, des écarts substantiels subsistent entre les résultats du dernier sondage Harris Interactive et le verdict des urnes. Alors si ni les dynamiques, ni les écarts entre sondeurs ne suffisent à expliquer le résultat que nous reste-t-il ?

Et bien 3 pistes :

- La piste d’un défaut de méthodologie commun à tous les sondeurs. Notre notation de sondeurs est relative. Si tous les sondeurs avaient le même défaut, ce défaut ne viendrait pas différencier les instituts. Et il y aurait plusieurs sujets à creuser : inclusion des personnes peu à l’aise avec internet (alors que les sondages sont maintenant tous faits en ligne), biais induits par les (maigres) récompenses, etc.

- La piste du « herding », c’est-à-dire le fait que les sondeurs ne comparent entre eux pour éviter de sortir des chiffres trop différents les uns des autres, avançant ainsi en « troupeau ». C’est notamment la piste avancée par Nate Silver, statisticien et fondateur du site FiveThirtyEight sur Twitter en réaction aux résultats du 1er tour du 10 avril.

- La piste d’un comportement difficile à anticiper de groupes d’électeurs, rendant caduque les échantillonnages réalisés par les sondeurs ? Ici aussi, plusieurs pistes à creuser : mobilisation massive dans les derniers jours de personnes n’étant jusque là pas décidées à voter, sous-mobilisation de parties de la population…

Ou peut-être, un peu de tout ça à la fois ?

Merci à Nsppolls pour son travail impressionnant de collecte et de mise en format JSON de l’ensemble des sondages de l’élection présidentielle 2022, essentiel à cette analyse. Allez rendre visite à leur GitHub, ou faites un don pour soutenir leur projet.